「音声認識の第2次ブームといわれる今に至るまでには何が起こっていたのか。開発を進める主な企業の歴史から音声認識技術の変遷を追う」

引き続き、音声認識技術の開発を進めている主な企業に焦点を当て、その歴史から音声認識技術の変遷を追ってみたい。今回はマイクロソフトについて紹介する。

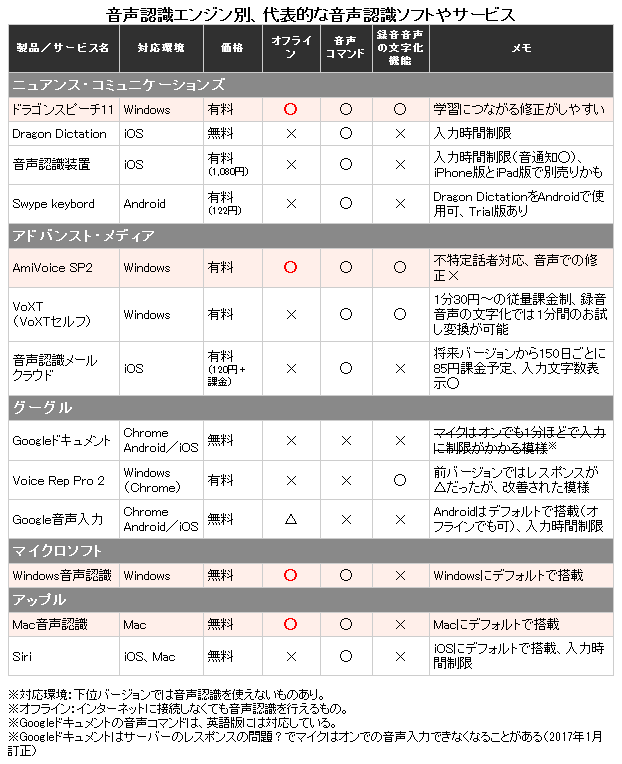

>>ニュアンス・コミュニケーションズはこちら

>>アップルはこちら

>>グーグルはこちら

■マイクロソフト

アメリカ合衆国に本社を置く世界最大のコンピュータ・ソフトウェア会社であるマイクロソフト。WindowsやOfficeソフトはおなじみであるが、音声認識にも膨大な時間と資金を投入し、技術開発を進めてきている。

2007年には当時音声認識技術市場の有力企業であったTellme Networksを買収することによって音声認識分野における取り組みを拡大している。

【参考】Microsoft,音声技術のTellme Networksを買収へ,音声認識機能の強化狙う(2007/03/15)

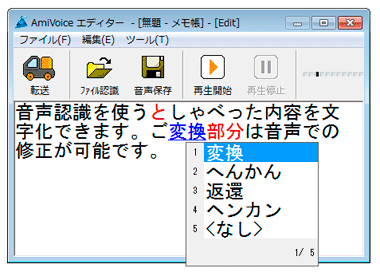

パソコン向けとしてはWindowsやOfficeソフトに音声認識機能を標準搭載しているほか、自動車向けの音声認識プラットフォームやモバイル向けの音声認識ソリューションの開発、また、最近では家庭用ゲーム機「Xbox」などにも転用している。

さて、次の記事によれば、マイクロソフトが音声認識の技術に投資しているのは少なくとも1991年から、とのこと。マイクロソフトの会長であるビル・ゲイツ氏は長年、近い将来コンピュータを音声やタッチ操作などで制御するようになる日が来るだろうと言い続け、マウスやキーボードに加え、音声、タッチ操作、手書き入力など、より自然な方法を用いたコンピュータの操作を社内外で熱心に提唱してきたという。

【参考】MS会長B・ゲイツ氏の退任後の役割と残されたタスク(2007/10/2)

【参考】ビル・ゲイツ氏が語る音声認識の未来とナチュラルインターフェース(2007/11/1)

実際、ビル・ゲイツ氏が提唱してきたように音声やタッチ操作など、人間の自然な動作によってコンピュータを操作できるインターフェースが現在は増えてきている。そして、このようなインターフェース全般のことを現在はNUI(ナチュナル・ユーザ・インターフェース)と呼んでいる。

つまり、NUIとは「触る」「動く」「話す」「考える」といった人間の自然な動作によって機械に命令を伝えることのできる仕組みを指す。身近な例としては、スマートフォンで当たり前となったタッチパネルは「触るUI」、Siriなどの音声アシスタント機能は「話すUI」に対応する。音声はNUIの広大な世界の一部であり、「話すUI」とは、音声認識技術を活用したUIということだ。

人間の声や自然な動作でコンピュータを操作できるNUIは、近年GUI(グラフィカル・ユーザ・インターフェース)に代わって開発や実用化が進められているUIであり、MS-DOSを代表とする文字ベースのCUI(キャラクターベースド・ユーザ・インターフェース)で始まったマイクロソフトの歴史は、マウスやキーボードなどを使ってオブジェクトを操作するGUIを経て、まさに今、NUIの時代へ突入しつつある。

マイクロソフトは早い時期からNUIに取り組んできた。1991年にマイクロソフトの基礎研究部門として「Microsoft Research」が設立されているが、そこでは音声認識、NUIなどといった革新的な技術の研究開発が進められている。そして、その研究開発成果は数多くのマイクロソフト製品に反映されてきている。

NUIの取り組みの一つとしては、ハンズフリーコントローラの「Kinect(キネクト)」が挙げられる。Kinectは、光学カメラや赤外線センサーが複数内蔵されるだけでなく、本格的な音声操作機能も搭載されているため、キーボードやマウスを使うことなく身体の動きや声でコンピュータを操作できる。

当初は家庭用ゲーム機「Xbox 360」用のデバイスとして発売されたが、後にWindowsにも対応し、日本でも2012年に「Kinect for Windows」が発売され、Kinectを組み込んだ製品の自由な開発が可能になった。現在は「Kinect for Windows」を応用することにより、非接触型画像操作システム「Opect(オペクト)」や障がい者活動支援ソリューション「OAK」などが医療の現場等で利用されるようになってきている。

【参考】マイクロソフトがUIの進化を語る、NUIの発展を牽引するKinectとMSRの研究事例(2013/01/29)

ただ、最近では音声認識やタッチ操作に対応するものも増えてきているが、従来型のGUIを拡張したUIはNUIの完成形とはいえない、ということである。GUIとNUIの本質的な違いは、状況や環境に応じた判断や機械学習にあるとのことだ。音声であれば、人間とコンピュータの間でしっかりした会話が成立するかといったことなどがNUIでは求められるという。

【参考】マイクロソフト、Kinectをはじめとした「NUI」の活用・研究事例を解説(2013/01/29)

これについては、私は次の記事に書かれている「人工知能を活用した受付システムの技術」をイメージした。「話すUI」の完成形としては、まさにこんな感じなのだろうと思う。なお、これは2010年の記事なので、実用化にはスペックでの制限うんぬんが書かれているが、これらの制約はクリアできる環境になってきつつあると感じる。

【参考】Microsoft Researchが生みだす新たな技術 – 米本社で見た最新のR&D(2010/05/13)

NUIはまだ進化の途中にあり、マイクロソフトは今後もNUIの研究開発に力を注いでいくようである。NUIが進化したとしてもコンピュータのUIが全てNUIに取って代わることはないとは思うが、今後どのようになっていくのか、興味深いところである。

最後に、次のニュースを紹介しておく。

≫Microsoft、Windows Phoneの音声機能を米国で強化、Bingの速度と精度が向上(2013/06/18)

マイクロソフトは、モバイルプラットフォーム「Windows Phone」においてDNN(ディープ・ニューラルネットワーク)を音声認識に適用することにより音声認識機能を強化し、Bingに対する音声検索の速度と精度のアップを実現したようだ。

DNNは、今まで音声認識技術で主流だった隠れマルコフモデル(HMM)を凌ぐ認識精度を得られることで、今注目されているアプローチである。だが、HMM以上に学習に時間がかかること、膨大なデータを集積しモデルを構築しなければならないということから、今まではなかなか定着しなかったといえる。

今回の成果は、先に述べた「Microsoft Research」と緊密に協力し、DNNと呼ばれる新たなアプローチで機能向上を実現したということである。「Windows Phone」においてではあるが、この成果がこれからのマイクロソフトのサービスに反映されるのは明らかだ。NUIの研究開発にもきっと生かされていくことだろう。今後のマイクロソフトの動向を見守りたいと思う。

(続く)